在人工智能领域,LoRA(Low-Rank Adaptation)模型因其高效的适应能力和灵活性而受到广泛关注。本文将深入探讨LoRA模型的定义、特性、功能、实现原理,以及如何与Stable Diffusion(SD)整合,并介绍相关的开源社区,特别适合新手模型使用者。

一、什么是LoRA模型?

LoRA是一种高效的适应性方法,旨在通过减少模型的调优成本,提高大模型在特定任务上的表现。它通过引入低秩矩阵,使得在大规模预训练模型上进行微调时,仅需更新少量参数,从而减少计算资源的需求。

二、LoRA模型特性

- 高效性:LoRA设计的核心在于减少计算开销和存储需求,在保持模型性能的同时,实现快速微调。

- 适应性:通过低秩矩阵的引入,LoRA能够迅速适应不同任务,而无需全面更新模型参数。

- 可扩展性:LoRA可以与多种深度学习框架和模型架构结合使用,具有广泛的适用性。

- 灵活性:用户可以根据具体需求选择不同的低秩维度,以调整性能和效率之间的平衡。

三、LoRA模型的功能

LoRA模型的主要功能包括:

- 快速微调:在不同任务或数据集上,LoRA允许用户快速微调模型,适应新任务。

- 节省资源:由于仅需更新少量参数,LoRA能够有效节省存储空间和计算资源。

- 提升性能:在特定任务上,LoRA通过优化参数配置,可以显著提升模型的表现。

四、LoRA模型实现原理

LoRA的实现原理基于线性代数中的低秩近似。具体来说,它将原始模型的权重矩阵分解为两个低秩矩阵的乘积。通过这种方式,用户只需优化这两个小矩阵,而不必调整整个模型的所有参数。这种方法大幅降低了训练时的内存占用和计算复杂度。

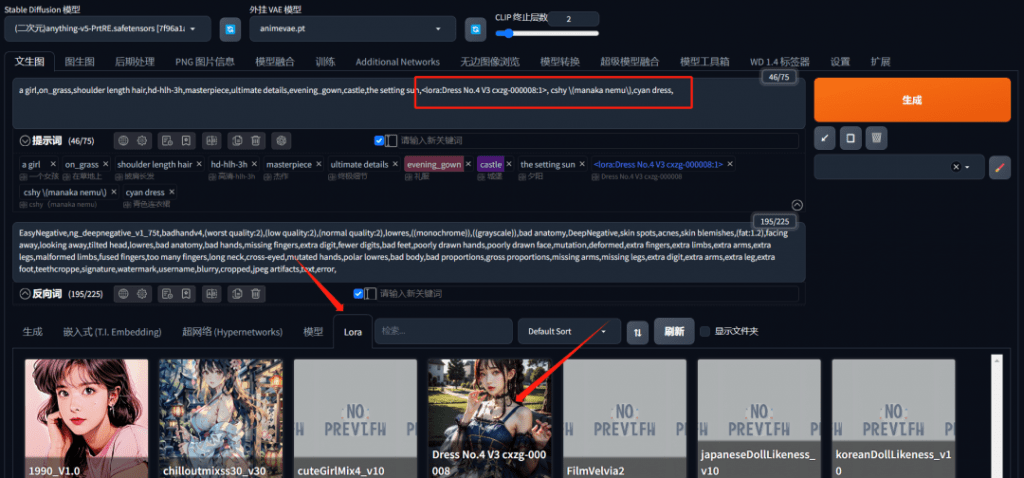

五、LoRA模型如何整合SD使用

将LoRA模型与Stable Diffusion(SD)整合可以提升生成图像的质量和多样性。整合过程如下:

Lora模型下载地址:https://civitai.com/

- 模型加载:首先,确保您已经安装了Stable Diffusion所需的环境,并下载预训练的Stable Diffusion模型。

- 配置LoRA:

- 下载LoRA的实现代码,通常在GitHub上可以找到相关的开源项目。

- 在SD模型的配置文件中,添加LoRA相关参数,通常包括设置低秩矩阵的维度和应用位置。

- 应用LoRA:

- 在模型的某些层引入LoRA,通过插入低秩矩阵来替代部分原始参数。例如,您可以选择在生成器的某些卷积层应用LoRA。

- 这样,您便可以在训练时微调这些低秩矩阵,而不是整个模型。

- 微调过程:

- 针对特定的图像生成任务,您可以使用自己的数据集对LoRA进行微调,确保模型能够在保留原有特征的基础上,产生更符合需求的输出。

- 使用适当的损失函数和优化算法进行训练,以提高生成效果。

- 测试与优化:

- 在生成图像后,评估模型输出的质量,并根据结果进行调整。您可以反复调整LoRA参数,观察其对生成效果的影响。

通过这样的整合,LoRA不仅能提升SD模型的性能,还能让您在资源有限的情况下实现更高效的训练。